Algorithmen haben längst die Kontrolle über einen grossen Teil unseres Alltags übernommen. Unsere Google-Suchergebnisse werden aufgrund Daten ausgespielt, die wir massenhaft und nebenbei abliefern. Und nicht nur dort können wir ein selbstlernendes System entfesseln, das uns durch unseren Alltag helfen will.

Sei es beim Einkaufen, Video schauen oder bei intelligenten GPS-Systemen. Wir sind von Systemen umgeben, die sich selbst weiterentwickeln. Wie autonom soll dieses Lernen aber stattfinden?

Ein anderer Umgang als mit Computern

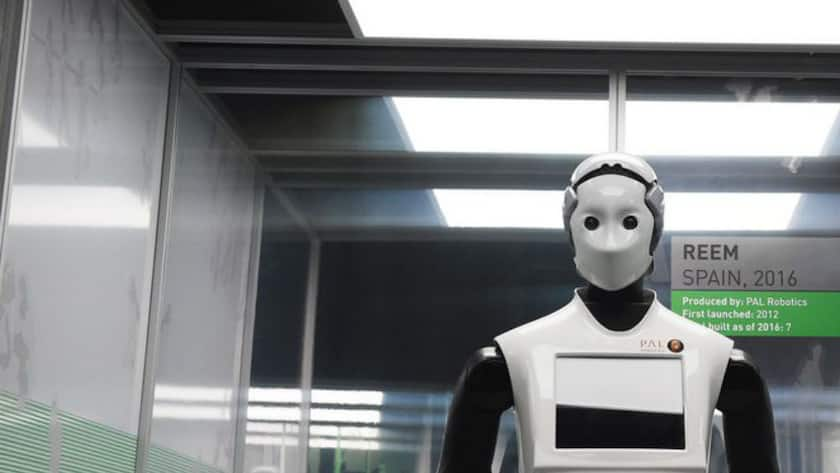

«An Computer haben wir uns gewöhnt und auch den Umgang mit Robotern können wir uns vorstellen. Sie tun das, wofür sie programmiert sind, und wenn etwas schiefläuft, kann man sie abschalten oder auf die Werkseinstellungen zurücksetzen», erläutert Matthias Mölleney, Leiter des Center for Human Resources Management & Leadership an der Hochschule für Wirtschaft Zürich.

Bei künstlicher Intelligenz sei das nicht so einfach – da geht es um lernende Systeme, die in der Lage sind, selbständig Probleme zu bearbeiten und aufgrund eigener Lernerfahrungen Entscheidungen zu treffen. «Wie steuert man diesen Prozess? Kann oder muss man sogar Zielvereinbarungen treffen mit solchen intelligenten Systemen?», fragt Mölleney.

Kooperieren mit Maschinen

Wer diese Frage beantworten will, muss erst einmal analysieren, welche Formen der Interaktion mit lernenden Systemen, bisher Menschen, wir bereits kennen. Der Philosoph Julian Nida-Rümelin erklärte kürzlich bei einem Vortrag vor der Zürcher Gesellschaft für Personal-Management, dass es drei Formen von Interaktionen gibt.

Erstens die klassische Form der Weisung, jemand befiehlt und jemand führt aus. Zweitens eine Art Marktmodell, Menschen verfolgen Interessen und steuern so ihre Interaktion. Drittens spricht Nida-Rümelin vom Modell der Kooperation. Er geht davon aus, dass dieses das dominierende in der neuen Wirtschaftswelt sein wird.

Der bisherige Ansatz ist überholt

Aber wie ist ein kooperatives Modell auf Maschinen anwendbar? Das Weisungsmodell ist für hochentwickelte AI-Anwendungen (Artificial Intelligence) ohnehin überholt. «Wenn künstliche Systeme nicht nur auf die Optionen angewiesen sind, die von ihren Entwicklern vorprogrammiert werden, brauchen wir Leitlinien», erklärt Mölleney.

Der Ausschaltknopf oder die Reset-Taste, die wir vom Umgang mit den bisherigen technischen Systemen kennen, hilft nicht mehr weiter.

Eine Grundfrage steht im Zentrum

Dabei geht es auch um die Grundfrage, ob wir bei der Entwicklung künstlicher Intelligenz die Chance haben, Probleme, die wir im Entscheidungsverhalten von Menschen vorfinden, also irrationale, von persönlichen Problemen beeinflusste oder verzerrte Entscheidungen, zu überwinden, oder ob wir durch Systeme, deren Entwicklung wir nicht steuern, solche Probleme wiederholen.

Wird künstliche Intelligenz also die Probleme menschlicher Entscheidungen haben, nur ausser jeder Kontrolle?

Firmenkultur im Algorithmus

Das HR könnte sich in der Implementierung und Entwicklung von AI-Systemen frühzeitiger einschalten und sogar auf die Implementierung gewisser Werte im Verhalten eines Algorithmus drängen, etwa bei einem System, das Bewerberdossiers auswählt. Tatsächlich wäre eine stärkere Integration von Erfahrungen aus der Personalarbeit in die Programmierung solcher Systeme gefragt.

Ob in den Personalabteilungen aber überhaupt das Wissen und Interesse besteht, sich mit so einem Thema zu befassen, darf angezweifelt werden. Vor allem, wenn man HR nur als eine Hilfsdienstleistung des Geschäfts versteht und nicht als einen Träger von unternehmenskulturellen Werten, die auch in einem Algorithmus vorkommen können.

Neue Aufgabe für Personalarbeiter

Die Personalarbeiter könnten auch eine Aufgabe darin finden, Mitarbeiterinnen und Mitarbeiter für ein neues Verhältnis zur Maschine zu schulen. Unser jetziges Verhältnis zu Maschinen haben wir alle mit PCs gelernt, die wir im Notfall ausschalten oder völlig zurücksetzen lassen konnten.

Eine IT-Abteilung steht im Notfall zur Verfügung. «In den letzten dreissig Jahren haben wir lernen müssen, wie man mit Geräten umgeht und sie effektiv einsetzen kann. Wenn etwas nicht wie geplant funktioniert hat, haben wir uns dabei oft den Vorwurf der diversen Help Desks anhören müssen, dass es nur an einem Benutzerfehler liegen kann», so Mölleney. Beim Einsatz von künstlicher Intelligenz ist auch das nicht mehr so einfach.

Ein neues Verständnis tut not

Es braucht also ein viel tiefer gehendes Verständnis von Technologie und Interaktion mit dieser Technologie, die sich auch in der Bürowelt immer stärker ausbreitet (siehe Box), wie sie es in jedem Wirtschaftsbereich tut. Die wichtigsten Grundsätze, die wir aus funktionierender menschlicher Interaktion kennen, wie Vertrauen, Wahrhaftigkeit und Tugendhaftigkeit, also eine Art moralisch einwandfreies Verhalten, sind schwierig auf selbstlernende Systeme zu übersetzen.

Dennoch ist eine Debatte darüber notwendig. Ebenfalls denkbar ist, dass sich die Teamarbeit durch die teilweise Integration von selbstständigen, technisch basierten Entscheidungssystemen weiterentwickelt und dann vor völlig neuen Herausforderungen steht. Die Frage nach der Führung von künstlicher Intelligenz ist jedenfalls noch nicht beantwortet, wird aber entscheidend sein.

Künftig überflüssig: Diese Jobs werden in der Schweiz automatisiert