Frau Diethelm, künstliche Intelligenz (KI) ist in aller Munde, die Begeisterung hoch. Was macht diese Faszination aus?

Die Faszination ist technologischer Art – Personen können plötzlich in einer natürlichen Art mit einer Maschine interagieren. Das trauten sie ihnen bisher nicht zu und sind jetzt verblüfft, wie schnell beispielsweise Chat GPT Antworten liefert, die auch brauchbar sind.

Sie verweisen aber trotz der Faszination auf die Probleme der KI.

Ja, denn leider liegen allen künstlichen Intelligenzen – egal ob Text, Sprache, Bild oder Musik – die gleichen Probleme zugrunde.

Name: Cornelia Diethelm

Funktion: Expertin für Digitale Ethik und Unternehmerin

Alter: 50

Wohnort: Kölliken AG

Ausbildung: Masterstudium in Politikwissenschaft, Betriebs- und Volkswirtschaft (Master in Arts) an der Universität Bern, MAS Digital Business an der Hochschule für Wirtschaft Zürich HWZ sowie Studiengang Technoethik an der Rheinland-Pfälzische Technische Universität Kaiserslautern-Landau (RPTU)

Die da sind? Welche Probleme können so generisch sein und auf alle KI zutreffen?

Es gibt drei grosse Probleme, allen voran das Potenzial für Diskriminierungen. Ganz grob – und das sage ich ohne Vorurteile – heisst das: Alles, was vom «weissen Mann» abweicht, ist anfällig für Diskriminierung.

Wieder der weisse Mann?

Ja, wieder der weisse Mann. Der Grund ist, dass von dieser Population schlichtweg am meisten Daten vorhanden sind. Und da die Basis von künstlichen Intelligenzen riesige Datenmengen sind, lernt eine KI natürlich überproportional stark von dieser Gruppe.

Sie sprachen von drei Problemen – welche zwei bestehen noch?

Einerseits die Problematik von Stereotypen. KI-Modelle basieren auf der Vergangenheit, auf Daten, die wir bereits besitzen. In der Vergangenheit lebten wir aber nach anderen gesellschaftlichen Modellen – beispielsweise dem, dass die Frau zu Hause blieb.

Das heisst, wir nutzen Informationen aus der Vergangenheit und halten so die Stereotype aufrecht?

Nicht nur aufrecht, sie werden durch die KI sogar verstärkt und in die Zukunft getragen. Ein anderes Beispiel ist die Dominanz der westlichen Kultur. Wer eine KI nach einer Hochzeit befragt, stösst zwangsläufig auf die weisse Hochzeit – dabei gibt es so viele andere Hochzeitsrituale auf der Welt. Wir nehmen solche Elemente nicht bewusst wahr, aber sie führen im Unterbewusstsein dazu, dass wir die weisse Hochzeit als die einzig wahre wahrnehmen – oder eben einer Frau im Arbeitskontext weniger zutrauen, weil sie primär mit dem Zuhause assoziiert wird.

Diskriminierung, Stereotype – es fehlt noch ein Problem?

Künstliche Intelligenzen tendieren zum Durchschnitt. Das wiederum fördert die Standardisierung und nicht die Vielfalt. Grund ist, dass die KI oft mit einseitigen Daten trainiert wird, weshalb sie die Vielfalt der realen Welt nicht kennt.

Worauf ist das zurückzuführen? Reine Faulheit der Programmierer?

Die Statistik arbeitet mit der Glockenkurve: Alles, was in der Mitte ist, wird erfasst; Randelemente werden weggelassen. Das ist effizient. In Zusammenhang mit der Programmierung einer KI ist das die günstigste und schnellste Lösung, damit grosso modo etwas funktioniert.

Aber nicht die Realität?

Genau. Was nur 08/15 abgezeichnet wird, ist auch 08/15. Es ist Mainstream – aber das geht in Bezug auf Menschen schlichtweg nicht. Im Extremfall setzt eine KI, die zum Beispiel mit unzureichenden Daten von Menschen mit dunkler Haut oder asiatischen Mandelaugen trainiert wurde, ebendiese Leute in Verbindung mit Tieren – oder erkennt sie schlichtweg nicht. Das macht sie nicht aus böser Absicht, aber ihr stehen schlicht keine anderen Daten zur Verfügung!

Und jetzt natürlich die Frage aller Fragen: Wie löst man diese Probleme?

Die Frage ist: Wer kann wie korrigierend eingreifen? Eine Lösung wäre, mit synthetisierten Datensätzen zu arbeiten. Synthetisiert heisst künstlich erzeugte statt reale Datensätze.

Sie nutzen den Konjunktiv?

Es gibt einen Trend zum sogenannten Solutionismus. Dank Big Data soll die Welt zu einem besseren Ort werden, dafür muss aber die Datengrundlage stimmen. In Bezug auf Sachgegenstände mag vieles möglich sein, aber wenn wir glauben, dass sich alle Probleme mit Daten lösen lassen, dann ist das problematisch. Zum Beispiel sind das Verhalten und die Persönlichkeit eines Menschen einzigartig und an einen bestimmten Kontext gebunden. Daten erfassen nur einen beschränkten Teil unseres Lebens, weshalb wir immer gut überlegen müssen, wo uns Daten einen Mehrwert bieten können.

Die weltweit erfolgreiche App Lensa generiert auf der Grundlage von Selfies Porträts von Nutzerinnen und Nutzern – als Superheld, Göttin oder Avatar.

Das Problem: Frauen werden sehr häufig zu Sexobjekten mit zweideutigen Blicken, tiefen Ausschnitten und viel Haut degradiert.

KI-Rekrutierungsprogramme unterstützen bei der Durchsicht von Bewerbungen. Sie analysieren die Dokumente anhand vorprogrammierter Elemente.

Das Problem: In den USA erfolgte eine Diskriminierung von schwarzen Frauen, weil das Tool vor allem durch weisse Männer programmiert wurde.

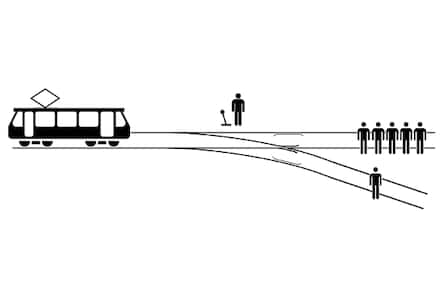

Man stelle sich vor, ein Zug rast auf eine Menschengruppe zu. Jemand kann entscheiden, eine Zugweiche zu stellen – womit eine Person sterben wird – oder das nicht zu tun, womit alle Insassen sterben werden. Wie soll man handeln?

Das Problem: Bei selbstfahrenden Autos beispielsweise müssen diese Fragen von KI entschieden werden. Soll ein selbstfahrendes Auto ausweichen oder eine Menschengruppe überfahren?

Der Solutionismus ist also trotz dem Namen nicht die Lösung. Was braucht es?

Anbieter von KI müssen ihre Teams divers gestalten, zum Beispiel in Bezug auf Kultur, Geschlecht, Alter, Ausbildung. Diverse Teams sind sensibilisiert und schauen, dass Daten vielfältig sind.

Was kann ich als Individuum machen, das beispielsweise Chat GPT nutzt?

Der Beitrag jedes und jeder Einzelnen ist relativ überschaubar. Als Individuum kann man Druck auf den Anbieter ausüben und verlangen, dass sie die Systeme diskriminierungsfrei aufbauen. Man kann bei Chat GPT auch direkt Rückmeldung geben mit einem Daumen hoch oder melden, dass Doctor mit Arzt übersetzt wird – aber auch eine Ärztin sein könnte. Unsere Verantwortung ist nur flankierend. Der grösste Impact liegt bei der Entwicklung und dem Einsatz der Systeme.

Zurzeit arbeitet die EU einen Vorschlag für ein KI-Gesetz aus – den AI Act. Ist eine Regulierung wirklich die Lösung?

Künstliche Intelligenz funktioniert nur, wenn wir uns auch der damit einhergehenden Verantwortung bewusst sind. Die EU arbeitet mit dem AI Act ein Gesetz aus, das Anwendungen von KI regulieren will, die ein hohes Risiko tragen. Aktuell schwemmen nämlich auch unseriöse KI-Tools den Markt.

Von was für Tools sprechen Sie?

Im HR-Bereich beobachtet man vermehrt den Einsatz von KI. Oft ist sie aber nach 08/15-Kriterien aufgebaut und filtert Personen heraus, die nicht in das Schema passen. Eine geschulte Personalerin wüsste jedoch, dass sie wertvoll sind fürs Unternehmen.

Von wegen Jobverlust – diese Jobs entstehen dank künstlicher Intelligenz

Bald die Stelle verlieren wegen KI? Die Angst vor der Technologie ist gross – doch es gibt Chancen.

Geschieht das effektiv?

In den USA passierte es Amazon. Bei der Rekrutierung wurden systematisch Frauen aussortiert. In Österreich probierte das Arbeitslosenamt ein KI-System aus, das die Arbeitslosen in drei Gruppen einteilte: diejenigen, die schnell einen Job finden, die Hoffnungslosen und die dazwischen, die man betreut und berät. Das Problem: Die KI wurde mit Arbeitslosendaten der Vergangenheit trainiert. Daraus resultierte, dass eine Frau mit Kindern automatisch zu den Hoffnungslosen gehörte!

Es gilt also auch aufseiten Entscheidungsträger eine gewisse Vorsicht gegenüber dem Einsatz neuer Technologien?

Absolut! Entscheidungsträger sind fasziniert, was mit Daten und neuen Technologien wie KI möglich ist. Dabei vergessen sie manchmal die Risiken und unerwünschten Nebenwirkungen. Zum Beispiel sind sie für Themen wie Diversität und Inklusion sensibilisiert und möchten diese fördern. Dann setzen sie ein fragwürdiges Tool ein und das führt zu Rückschritten. Das ist brandgefährlich.

Man will aber den Anschluss nicht verpassen und gut dastehen?

Es ist ein wenig wie bei der Nachhaltigkeit. Man hat den Innovationsdruck und ein persönliches Ego. Man will sich innovativ darstellen, besser sein als die Konkurrenz. Also lässt man sich von den neuen technologischen Möglichkeiten leiten – statt wirklich ein Problem zu lösen.

Und Sie als Ethikerin bremsen die Begeisterung. Bremsen Sie auch den Fortschritt?

Nein, ich bin ja selber fasziniert von vielem, und die Ethik muss den Fortschritt nicht bremsen. Doch es ist gefährlich, wenn wir heute das Gefühl haben, alles Technologische sei ein Fortschritt. Wir müssen uns die Frage stellen, was unser Leben wirklich besser macht, und was eben nicht.